Reducción de la pérdida: tasa de aprendizaje

Machine LearningMay 16, 2018

Como se observó, el vector de gradiente tiene una dirección y una magnitud. Los algoritmos de descenso de gradientes multiplican la gradiente por un escalar conocido como tasa de aprendizaje (o tamaño del paso en algunas ocasiones) para determinar el siguiente punto. Por ejemplo, si la magnitud de la gradiente es 2.5 y la tasa de aprendizaje es 0.01, el algoritmo de descenso de gradientes tomará el siguiente punto 0.025 más alejado del punto anterior.

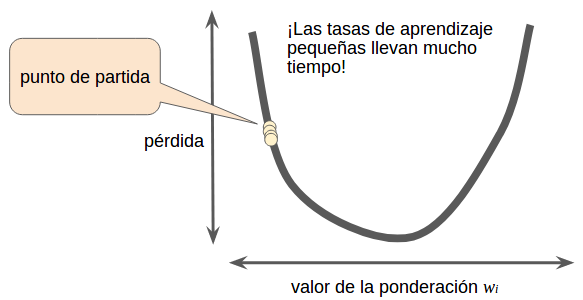

Los hiperparámetros son los controles que los programadores ajustan en los algoritmos de aprendizaje automático. La mayoría de los programadores de aprendizaje automático pasan gran parte de su tiempo ajustando la tasa de aprendizaje. Si eliges una tasa de aprendizaje muy pequeña, el aprendizaje llevará demasiado tiempo:

Figura 6. La tasa de aprendizaje es muy pequeña.

A la inversa, si especificas una tasa de aprendizaje muy grande, el siguiente punto rebotará al azar eternamente en la parte inferior, como un experimento de mecánica cuántica que salió muy mal:

Figura 7. La tasa de aprendizaje es muy grande.

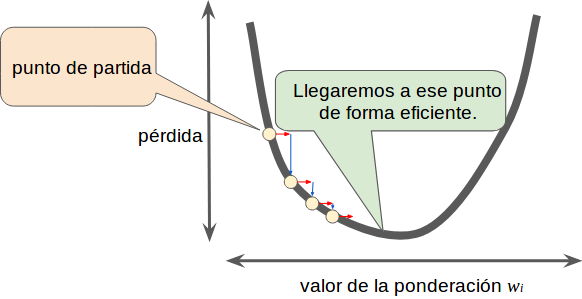

Hay una tasa de aprendizaje con valor dorado para cada problema de regresión. El valor dorado está relacionado con qué tan plana es la función de pérdida. Si sabes que el gradiente de la función de pérdida es pequeño, usa una tasa de aprendizaje mayor, que compensará el gradiente pequeño y dará como resultado un tamaño del paso más grande.

Figura 8. La tasa de aprendizaje es la correcta.

William Arevalo

Data Scientist • Bogotá, CO • willarevalo.developer@gmail.com

Passionate Data Scientist | Scrum amateur | Pentester | Services Admin | Calisthenics devotee